Wat is robots.txt?

Robots.txt is een tekstbestand dat in de hoofdmap (root directory) van een website wordt geplaatst. Het geeft instructies aan zoekmachine crawlers (ook wel bots genoemd) over wat ze van een website mogen crawlen en indexeren. Deze instructies zijn aangeduid als user agent en disallow regels. De user agent regel identificeert de specifieke crawler waarop de regels van toepassing zijn, zoals: Googlebot. De disallow regel geeft aan welke URL’s of paden de crawler moet vermijden. Alle grote zoekmachines, zoals Google, Bing en Yahoo respecteren de instructies.

Robots.txt: wat betekent het voor SEO?

Robots.txt assisteert crawlers bij het identificeren welke secties van een website ze mogen doorzoeken. Dit is met name van belang voor omvangrijke websites met talrijke pagina’s, aangezien het helpt om het crawl budget te optimaliseren. Een correct geconfigureerd bestand garandeert dat belangrijke pagina’s worden gecrawld en geïndexeerd, terwijl minder belangrijke of dubbele content kan worden uitgesloten. Bovendien kan de “allow” regel in het bestand zoekmachines expliciete toestemming geven om bepaalde content te crawlen, zelfs als deze zich in een uitgesloten directory bevindt.

In het kader van SEO campagnes is robots.txt een bepalend instrument. Het stelt SEO specialisten in staat om te controleren wat er wordt geïndexeerd. Dit kan assisteren bij het identificeren van problemen met de zichtbaarheid van de website en het verbeteren van de algehele SEO prestaties.

Hoe ziet een Robots.txt er uit?

Laten we een eenvoudig voorbeeld nemen om te begrijpen hoe een robots.txt bestand eruitziet. Stel je hebt een website en je wilt niet dat de zoekmachines een bepaalde pagina, bijvoorbeeld je privé fotogalerij, indexeren. Je robots.txt zou er dan zo uit kunnen zien:

User-agent: *

Disallow: /mijn-prive-fotogalerij/

Hier zegt “User-agent: *” dat de regel van toepassing is op alle webcrawlers en “Disallow: /mijn-prive-fotogalerij/” instrueert hen om de pagina “mijn-prive-fotogalerij” niet te crawlen. Laten we een wat complexer voorbeeld nemen om dit te illustreren:

User-agent: *

Disallow: /private/

Allow: /private/public-page.html

Sitemap: https://www.booming.agency/sitemap.xml

In dit voorbeeld:

User-agent: *betekent dat de regels van toepassing zijn op alle bots.Disallow: /private/instrueert bots om geen pagina’s onder de /private/ directory te crawlen.Allow: /private/public-page.htmlgeeft bots toestemming om een specifieke pagina in de anderszins verboden /private/ directory te crawlen.Sitemap: https://www.jouwwebsite.nl/sitemap.xmlwijst bots naar de locatie van de sitemap van de website.

Het is belangrijk om te begrijpen dat de instructies niet bindend zijn; eerlijke bots zullen ze volgen, maar sommige bots kunnen ze negeren. Daarom is het belangrijk om geen gevoelige informatie te plaatsen in secties die je probeert te blokkeren.

Waar vind ik robots.txt?

Het bestand is te vinden in de root directory van een website. Je kunt het bekijken door “/robots.txt” toe te voegen aan het einde van een domeinnaam. Bijvoorbeeld: www.booming.agency/robots.txt.

Hoe werkt robots.txt?

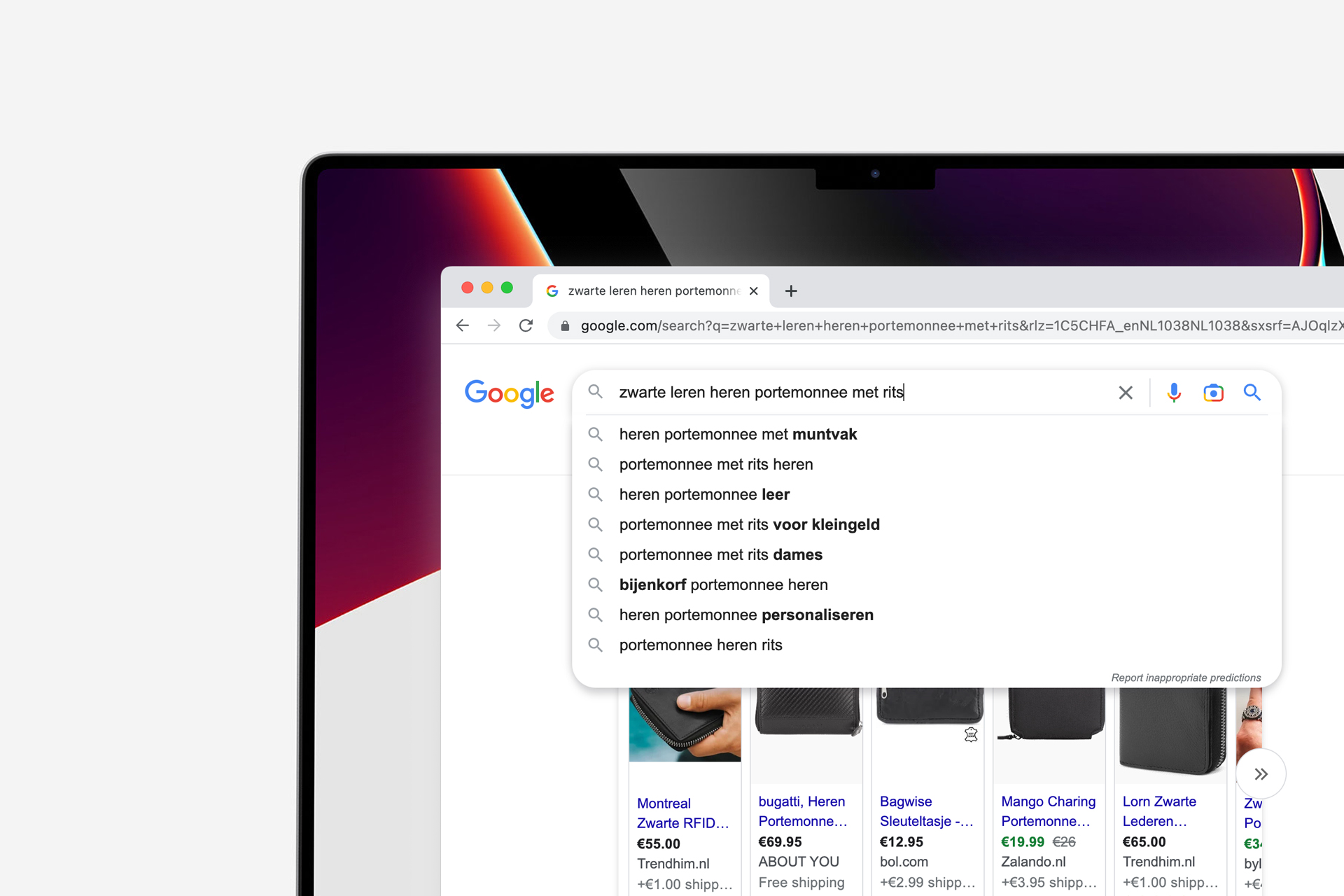

Wanneer zoekmachines het web crawlen, zoeken ze naar informatie en nieuwe pagina’s om aan hun index toe te voegen. Het proces begint meestal met een lijst van webadressen van vorige crawls en sitemaps die door website-eigenaren worden verstrekt. Zodra ze toegang krijgen tot een website, zoeken ze naar het robots.txt bestand voordat ze andere pagina’s crawlen. Dit bestand dient als een gids over welke secties van de website ze mogen bezoeken en welke ze moeten vermijden.

Hier zijn enkele kernpunten over hoe robots.txt werkt:

- Prioriteit van regels: als er conflicterende regels zijn, geven bots meestal prioriteit aan de meest specifieke regel.

- Crawl delay: je kunt een

Crawl-delayregel instellen om te voorkomen dat bots je server overbelasten door te snel te crawlen. - Wildcard: je kunt de wildcard [*] gebruiken om naar alle bots te verwijzen, of je kunt specifieke instructies geven aan specifieke bots door hun naam te gebruiken, zoals ‘

Googlebot'. - Volgorde van regels: de volgorde van de regels in robots.txt is belangrijk. Zorg ervoor dat je de regels logisch ordent om verwarring te voorkomen.

Crawler user agent

Een user agent verwijst naar de specifieke webcrawler waaraan de regels in het robots.txt bestand zijn gericht. Bijvoorbeeld, “Googlebot” is de user agent voor Google’s crawler, terwijl “Bingbot” die van Bing is. Je kunt regels instellen voor specifieke user agents of voor allemaal door het gebruik van een asterisk (*).

Robots Exclusion Protocol (REP)

Robots Exclusion Protocol (REP) is de technologie achter robots.txt, en het definieert hoe webcrawlers de instructies in het bestand moeten interpreteren en volgen.

Crawl budget

Het crawl budget verwijst naar de hoeveelheid pagina’s die een zoekmachine zal crawlen op je site binnen een bepaalde tijd. Het is essentieel om het crawl budget efficiënt te gebruiken om ervoor te zorgen dat belangrijke pagina’s worden gecrawld en geïndexeerd.

Noindex meta directive

De noindex meta directive kan worden gebruikt om te voorkomen dat bepaalde pagina’s worden geïndexeerd, zelfs als ze worden gecrawld. Het is een aanvullend hulpmiddel naast robots.txt om controle te hebben over wat zoekmachines indexeren.

Veelgemaakte fouten

Het is belangrijk om fouten te vermijden bij het opstellen van een robots.txt bestand, omdat fouten kunnen leiden tot onbedoelde blokkering van belangrijke pagina’s voor zoekmachines. Enkele veelvoorkomende fouten zijn het per ongeluk blokkeren van belangrijke pagina’s, het gebruik van opmerkingen op een onjuiste manier, of het niet specificeren van een user-agent.

Geavanceerde functies van Robots.txt

Robots.txt kan ook worden gebruikt voor geavanceerdere functies, zoals het beperken van de crawlsnelheid van zoekmachines om serverbelasting te verminderen, of het specificeren van de locatie van sitemaps.

Hoe Robots.txt helpt bij het blokkeren van inhoud

Robots.txt kan effectief worden gebruikt om inhoud te blokkeren door specifieke URL’s of paden uit te sluiten van het crawlproces, wat handig kan zijn om bepaalde delen van een website privé te houden of duplicatie van inhoud te voorkomen.

Waar moet je rekening mee houden?

Bij het werken met robots.txt is het belangrijk om nauwkeurig te zijn in de instructies en regelmatig te controleren of het bestand correct functioneert om onbedoelde blokkering of indexering te voorkomen.

Het testen van het Robots.txt bestand

Het is belangrijk om het robots.txt bestand te testen. Dit doe je om ervoor te zorgen dat het correct werkt. Je kunt dit doen met behulp van de Robots.txt tester in Google Search Console. Deze tool kan je helpen eventuele fouten te identificeren en te corrigeren.